Voilà, on y est (accrochez-vous). Vous vous demandez peut-être pourquoi on insiste tant sur la mise en place d’une bonne organisation pour la création d’un jeu. C’est vrai, on pourrait se dire : « On balance les assets dans le moteur, et hop, ça roule ! ». Mais c’est pas si sûr… L’histoire montre que négliger son pipeline de contenu, c’est se diriger droit vers le fameux « asset hell ». En fait, c’est ce que nous allons explorer ensemble dans les prochains paragraphes : comment structurer un pipeline propre, mettre sur pied un système de versions efficace, et utiliser les bons outils pour éviter la galère. Ça vous parle ? Suivez le guide.

Pourquoi c’est crucial

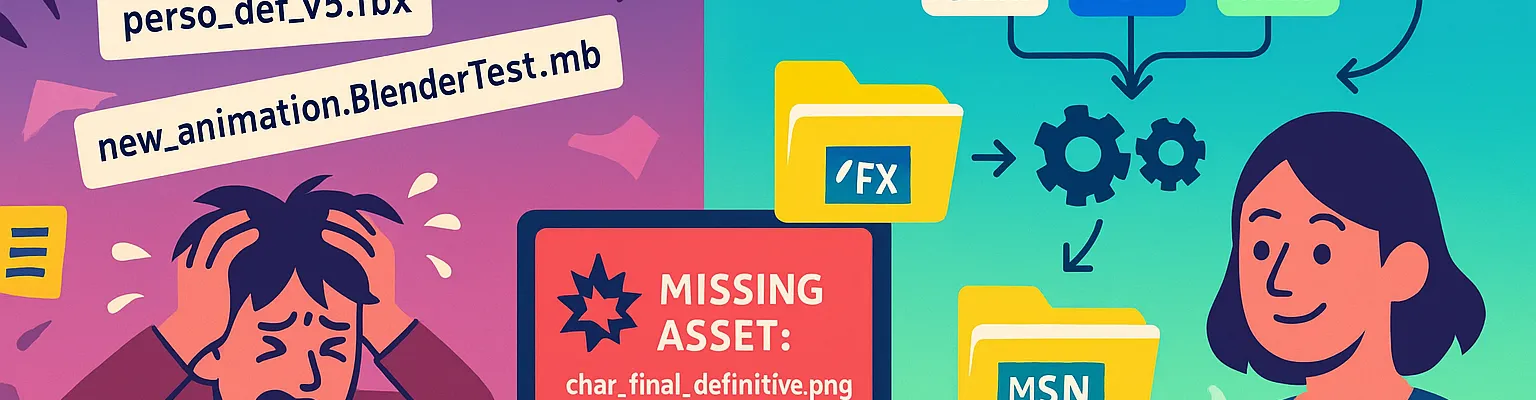

Un pipeline de contenu fiable, c’est la pierre angulaire d’un développement sans sueurs froides. Imaginez le bazar quand le dossier assets ressemble à un grenier mal rangé : on y trouve pêle-mêle des modèles 3D, textures, sons, tous nommés n’importe comment (du genre “character_final_final_v2.fbx”), et on ne sait plus qui a la version la plus à jour. Résultat ? Un build péteux, toujours prêt à exploser la veille d’une démo (c’est affolant, non ?). Alors qu’une pipeline bien pensée impose de l’ordre : on sait où ranger chaque asset, on a une intégration continue qui teste et reconstruit le jeu en boucle, on limite les surprises de dernière minute. L’équipe dort mieux, et chacun peut se consacrer à la création plutôt qu’à éteindre des incendies.

But du module

L’objectif est de décrire comment les assets voyagent de l’outil de création (3D, 2D, audio, etc.) jusqu’au jeu fonctionnel. On parle là d’un flux complet : depuis la création dans un logiciel (Blender, Maya, Photoshop) jusqu’au format final exploitable par le moteur. C’est un enjeu énorme, parce qu’un projet renferme un nombre fou de fichiers qu’il faut convertir, importer, ranger, pour que tout tourne lisse. Dans ce texte (et dans l’ensemble de cette formation en trois parties), on formalise :

- Les formats sources et l’import automatisé.

- Les conventions de nommage et la gestion de versions.

- L’intégration continue (CI/CD) et la production de builds.

- Les outils internes, comme les éditeurs de niveaux ou les exporters d’animations.

En clair, on veut savoir qui fait quoi (et comment), pour éviter de se mordre les doigts quand un asset important est introuvable la veille de la release.

Formats source et import automatisé

C’est top, non ? Mais attendez une minute… si on crée un modèle 3D dans .MB ou .MAX, comment le passer en .FBX ou en mesh optimisé, et dans quelles conditions ? L’idée, c’est que l’artiste n’ait presque plus rien à faire, à part cliquer “Enregistrer” (ou le faire automatiquement). Les systèmes modernes, Unity en tête, automatisent pas mal de ces étapes : dès qu’on dépose un .fbx, un script d’import se déclenche pour générer le mesh, éventuellement dans plusieurs résolutions, avec mipmaps pour les textures, etc. Tout ça évite les procédures manuelles (souvent synonymes d’oubli ou de variations inattendues).

Mais c’est crucial de bien paramétrer cette conversion, pour qu’un fichier .PSD 4096×4096, par exemple, soit compressé en .PNG ou .DDS au format voulu. Pareil pour l’animation : un simple script peut bêcher le bon framerate, la bonne échelle, l’axe de rotation. Vous voyez l’idée : plus on automatise, plus on s’épargne des migraines récurrentes. Et si un artiste préfère Blender à Maya, c’est pas un souci, du moment que la pipeline sait convertir derrière.

Nommage cohérent et gestion de versions (Git LFS vs Perforce)

Vous vous demandez peut-être : « Ok, c’est mécanique, mais est-ce vraiment important de nommer soigneusement ses fichiers ? » Eh bien oui, mille fois oui ! Un système de nomenclature clair (TX_ pour Texture, MDL_ pour Modèle, SND_ pour Son, etc.) fait gagner un temps fou quand on cherche où se trouve tel asset. En plus, ça ouvre la voie à des scripts qui traitent les fichiers selon leur préfixe. À l’inverse, un festival de “newV2_final_dernierCetteFois.fbx” nous plonge vite dans la confusion.

Ensuite, la gestion de versions : c’est un point clé pour toute équipe de création, parce qu’on manipule énormément de fichiers lourds. Git pur, c’est chouette pour le code texte, mais ça devient lourd quand il s’agit d’héberger des gigas de modèles 3D. C’est là que Git LFS ou Perforce entrent en jeu. Avec Git LFS, on reste dans l’écosystème Git (pratique et peu coûteux), mais on doit faire gaffe aux verrous de fichiers, parfois mal gérés. Perforce, lui, est très apprécié des studios pros (avec un verrouillage automatique, une intégration poussée dans certains moteurs), mais nécessite un serveur dédié et un budget licence plus costaud. Dans tous les cas, l’essentiel, c’est de verrouiller un fichier quand on l’édite, car on ne fusionne pas un .fbx comme on fusionne du code. Personne n’a envie de perdre 7 heures de modélisation parce que Jean-Michel a écrasé la version d’Élodie.

Intégration Continue, Build Farm et Patches (CI/CD)

C’est un autre pilier crucial. L’intégration continue, c’est le fait qu’à chaque commit (qu’il s’agisse de code ou d’un asset), un serveur récupère le tout, reconstruit le jeu et fait des tests de base. L’intérêt ? Détecter les problèmes aussitôt. Fini, le build qui crashe la veille d’une démo, parce qu’une texture 4K non compressée fait tout planter. On a souvent une build farm, c’est-à-dire plusieurs machines spécialisées pour compiler et convertir les assets. Comme ça, personne ne sacrifie son poste de travail à tourner en rond pendant des heures et tout le monde obtient des build “fresh” régulièrement.

Avec un pipeline de CI/CD, on peut aussi générer facilement des patchs. Au lieu de redéployer 100 Go de données, on envoie juste la différence entre la version précédente et celle à venir. C’est top, non ? Ça économise du temps, de l’espace et des crises de panique. Pour y parvenir, on stocke l’historique des builds et on compare les fichiers modifiés. Résultat : une mise à jour plus légère et plus rapide à tester. Et si tout se fait automatiquement, c’est encore mieux (moins d’étapes manuelles, moins de risques d’erreur).

Outils internes (éditeurs de niveau, exporters d’animation…)

Dans les grands studios, il est courant de développer des outils maison. Pourquoi ? Parce que parfois, les éditeurs intégrés (Unity, Unreal) ne correspondent pas exactement à la vision du projet. On crée alors un éditeur de niveaux interne pour un type de gameplay précis, ou un exporter d’animations sur Blender qui impose automatiquement les bons paramètres. L’intérêt, c’est d’éviter de tout reconfigurer à la main et de réduire les oublis. Un plugin d’export peut par exemple baker l’animation, appliquer la bonne échelle, choisir le bon dossier. Comme ça, la pipeline reste consistante d’un asset à l’autre.

Ça représente certes un investissement (il faut du temps, des compétences, un sprint dédié parfois), mais c’est un moulin à vent redoutablement efficace pour gagner en productivité. Le secret, c’est de viser un outil aussi intuitif que possible, pour que les artistes et designers s’en emparent. Personne n’a envie de batailler avec une interface austère alors qu’il suffit d’un bouton “Exporter vers le jeu”.

Points de vigilance

Étapes manuelles qui cassent la reproductibilité

Chaque fois qu’on dit “il faut cliquer ici et configurer ça” manuellement, on ouvre la porte à l’erreur. C’est dommage, non ? Un pipeline solide privilégie l’automatisation : c’est censé se dérouler toujours de la même façon, sans qu’un humain doive se souvenir de tel ou tel réglage. On évite ainsi le fameux “Mais hier, ça marchait, pourquoi plus aujourd’hui ?”. Voilà pourquoi on documente tout (tous les scripts, toutes les automatisations), ou mieux, on intègre ces manips directement dans des scripts irréprochables que chacun peut lancer.

Absence de validation automatique des assets

C’est l’autre piège : un artiste importe une texture absolument gigantesque et la laisse en 4K non compressée. Sur le moment, on se dit “Ça ira”. Mais le jeu se met à ramer, on ne sait plus pourquoi, et on perd des heures de debugging. Un petit script de vérification, c’est un gain de sérénité. L’asset qui enfreint les règles (trop polygoné, trop lourd, mauvaise nomenclature) est rejeté ou signalé, et hop, on prévient le problème avant qu’il ne pourrisse dans le build final. C’est aussi un moyen d’éduquer l’équipe aux bonnes pratiques.

Explosion des temps de build

Plus le projet grossit, plus la compilation et la conversion d’assets peuvent prendre de temps. On voit parfois des équipes attendre des heures qu’un build sorte. Et là, plus personne n’ose pousser ses changements avant la fin de la journée, de peur de bloquer les autres. C’est contre-productif. Les solutions ? Le build incrémental, le cache, la parallélisation, tout ce qui évite de tout recalculer à chaque fois. Sur Unreal, on profite du Derived Data Cache pour les shaders, et côté Unity, de son Cache Server. On peut même supprimer régulièrement les assets inutilisés pour alléger le projet. L’idée, c’est de rester dans une durée de build confortable (quelques minutes, voire une heure grand max, selon l’enjeu) pour ne pas démotiver l’intégration régulière.

Et voilà, le pipeline de contenu et les outils, c’est un voyage passionnant (et stratégique). Certes, ça demande de la rigueur, un peu d’organisation et un certain investissement en scripts et outils internes. Mais le gain ? Un développement plus serein, plus rapide et plus fiable. Plus jamais vous ne tremblerez à l’idée qu’un build casse tout juste avant une présentation clients : totalement le contraire de l’asset hell. Finalement, c’est ça, créer un TDD (Technical Design Document) complet autour de son pipeline : tracer un chemin clair pour chaque membre de l’équipe, réduire les frictions et garder le cap sur l’essentiel, la création d’un super jeu.